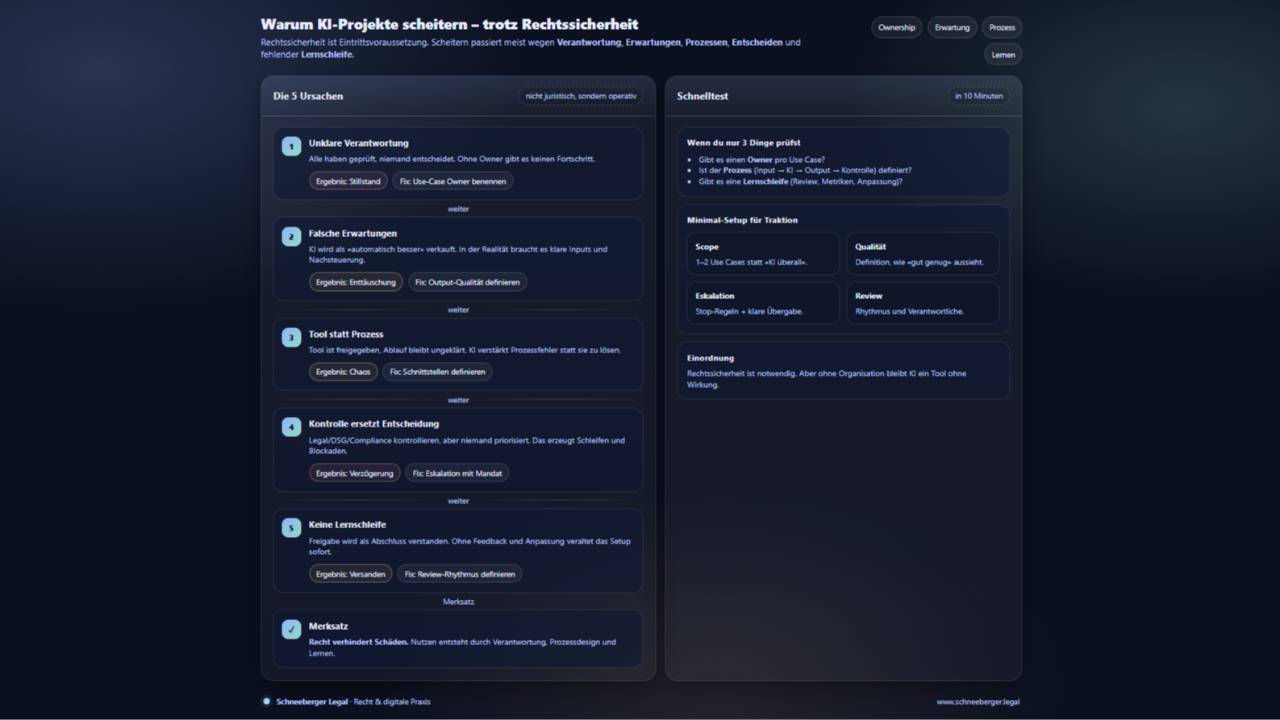

Warum KI-Projekte scheitern – obwohl sie rechtlich sauber sind

Jan 09, 2026

Kurzantwort

Die meisten KI-Projekte scheitern nicht am Recht. Sie scheitern an unklarer Verantwortung, falschen Erwartungen und fehlender Einbettung in bestehende Prozesse. Rechtssicherheit ist notwendig, aber nicht ausreichend.

Warum diese Beobachtung irritiert

Viele Organisationen investieren früh in:

-

Datenschutzprüfungen

-

Verträge

-

Richtlinien

-

Freigaben

Formal ist alles korrekt.

Und trotzdem kommt das Projekt nicht vom Fleck oder versandet nach kurzer Zeit.

Das sorgt für Frust, denn der implizite Gedanke lautet:

Wenn es rechtlich sauber ist, müsste es doch funktionieren.

Tut es oft nicht.

Der zentrale Denkfehler

Die Annahme lautet:

„Rechtssicherheit ist der kritische Erfolgsfaktor für KI.“

Das ist falsch.

Rechtssicherheit ist eine Eintrittsvoraussetzung, kein Erfolgshebel.

Sie verhindert Probleme – sie erzeugt aber keinen Nutzen.

Grund 1: Unklare Verantwortung

Rechtlich sauber heisst oft:

-

alle haben geprüft

-

niemand entscheidet

Wenn unklar ist:

-

wer den Use Case verantwortet

-

wer Nutzen und Risiko trägt

-

wer im Zweifel entscheidet

bleibt KI ein Experiment ohne Traktion.

Recht kann prüfen.

Es kann nicht führen.

Grund 2: Falsche Erwartungshaltung

Viele KI-Projekte starten mit der unausgesprochenen Hoffnung:

-

schneller

-

billiger

-

besser

-

automatisch

Die Realität ist nüchterner:

-

KI braucht Einbettung

-

KI braucht klare Inputs

-

KI braucht Nachsteuerung

Wenn diese Arbeit unterschätzt wird, entsteht Enttäuschung – nicht Mehrwert.

Grund 3: KI wird als Tool eingeführt, nicht als Prozess

Rechtlich sauber heisst oft:

-

Tool geprüft

-

Anbieter freigegeben

-

Nutzung erlaubt

Was fehlt:

-

Anpassung bestehender Abläufe

-

klare Schnittstellen

-

definierte Übergabepunkte

KI ersetzt keinen Prozess.

Sie verstärkt bestehende – inklusive ihrer Schwächen.

Grund 4: Kontrolle ersetzt Entscheidung

In vielen Projekten gibt es:

-

Datenschutz

-

Legal

-

Compliance

Alle kontrollieren.

Niemand priorisiert.

Das führt zu:

-

endlosen Schleifen

-

vorsorglichen Einschränkungen

-

Stillstand trotz Freigabe

Kontrolle ohne Entscheidung bremst mehr als jedes Risiko.

Grund 5: Kein Lernmechanismus

Rechtliche Abklärungen werden oft als Abschluss verstanden.

In der Praxis bräuchte es:

-

Feedback aus der Nutzung

-

Anpassung von Regeln

-

Nachschärfung von Annahmen

Ohne Lernschleife bleibt das Projekt statisch, während sich Realität und Technologie weiterbewegen.

Praxisreflexion

In erfolgreichen KI-Projekten ist das Muster umgekehrt:

-

Verantwortung ist klar

-

Recht setzt Leitplanken

-

Nutzung wird beobachtet

-

Regeln werden angepasst

Recht ist dort ein Enabler, kein Gatekeeper.

Kurze Einordnung für die Praxis

-

Rechtssicherheit verhindert Schäden

-

Verantwortung erzeugt Fortschritt

-

Prozesse schlagen Tools

-

Lernen schlägt Freigaben

Einordnung

KI-Projekte scheitern selten am Recht.

Sie scheitern daran, dass niemand bereit ist, Entscheidungsverantwortung zu übernehmen, sobald das Recht sein Okay gegeben hat.

Selbsttest

-

Ist klar, wer den Nutzen des KI-Use-Cases verantwortet?

-

Ist klar, wer priorisiert, wenn es Zielkonflikte gibt?

-

Gibt es eine Lernschleife jenseits der Erstfreigabe?

Wenn nicht, liegt das Scheitern nicht im Recht –

sondern in der Organisation.