Wer haftet für falsche KI-Auskünfte – und warum Disclaimer oft überschätzt werden

Dec 27, 2025

Kurzantwort

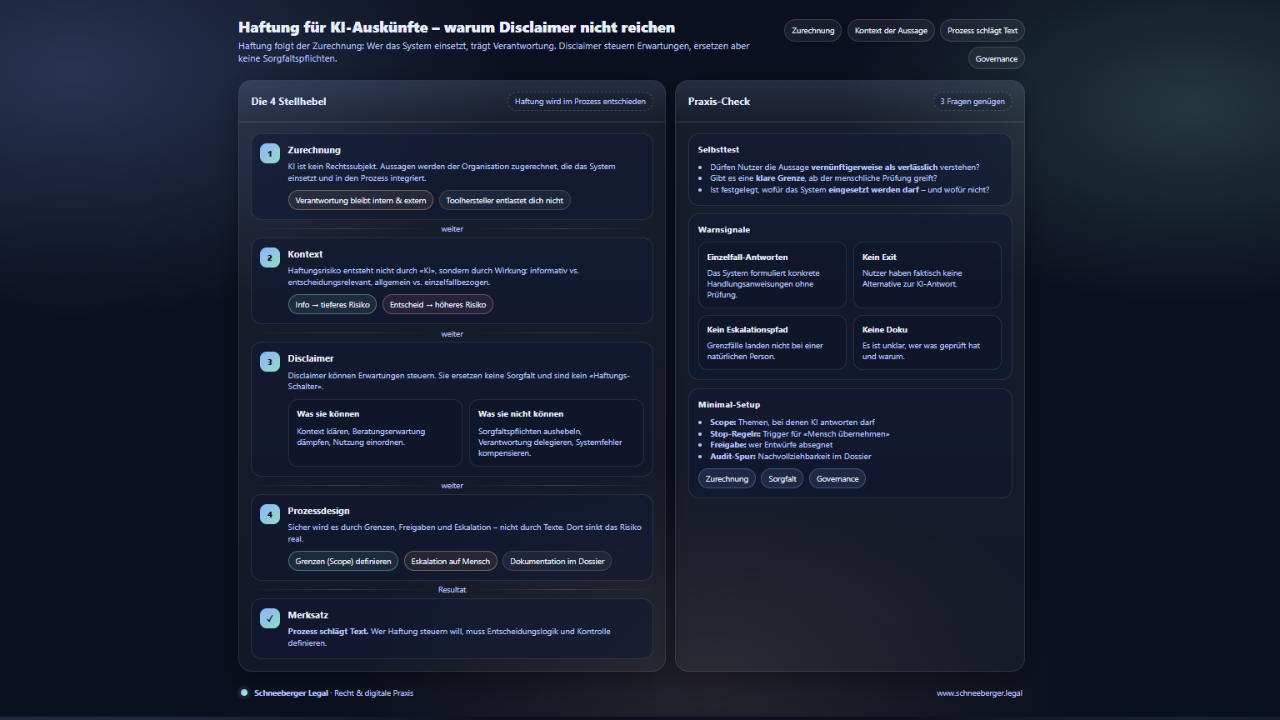

Für falsche oder irreführende KI-Auskünfte haftet nicht das System, sondern die Organisation, die es einsetzt. Disclaimer können Erwartungen steuern, ersetzen aber keine Sorgfaltspflichten. Wer Haftung vermeiden will, muss Prozesse gestalten – nicht Texte formulieren.

Warum diese Frage zentral ist

KI wird eingesetzt, um schneller zu antworten, zu informieren, zu entlasten.

Gleichzeitig wächst die Sorge:

Was, wenn das System etwas Falsches sagt – und jemand sich darauf verlässt?

Die verbreitete Reaktion:

Ein Hinweis, ein Disclaimer, ein Sternchen.

Rechtlich ist das zu kurz gedacht.

Der grundlegende Denkfehler

Viele Diskussionen starten mit der Frage:

„Haftet man für das, was die KI sagt?“

Die korrekte Frage lautet:

Wem ist die Aussage zuzurechnen – und in welchem Kontext?

KI ist kein Rechtssubjekt.

Sie handelt nicht selbstständig.

Sie ist ein Hilfsmittel im Verantwortungsbereich der Organisation.

Zurechnung: Warum die Verantwortung beim Unternehmen bleibt

Rechtlich entscheidend ist:

-

wer das System einsetzt,

-

wer es in einen Prozess integriert,

-

und wer von seiner Nutzung profitiert.

Ob eine Aussage

-

von einer Mitarbeitenden,

-

aus einer Textvorlage,

-

oder aus einem KI-System stammt,

ändert nichts daran, wem sie zugerechnet wird.

Die Organisation bleibt Trägerin der Verantwortung – nach aussen wie nach innen.

Was Disclaimer leisten – und was nicht

Disclaimer haben eine Funktion. Aber eine begrenzte.

Was sie können:

-

Erwartungshaltungen dämpfen

-

den Kontext der Nutzung klarstellen

-

signalisieren, dass keine individuelle Beratung erfolgt

Was sie nicht können:

-

gesetzliche Sorgfaltspflichten aushebeln

-

Verantwortung delegieren

-

systematische Fehler kompensieren

Ein pauschaler Hinweis „Diese Antwort wurde automatisch generiert“ ist kein Haftungsschutz.

Entscheidend ist der Kontext der Aussage

Ob eine falsche KI-Aussage haftungsrelevant ist, hängt nicht vom Tool ab, sondern vom Wirkungsrahmen:

-

Informativ oder entscheidungsrelevant?

-

Allgemein oder einzelfallbezogen?

-

Unverbindlich oder handlungsleitend?

Je näher eine Aussage an einer konkreten Entscheidung liegt, desto höher sind die Anforderungen an Kontrolle und Absicherung.

Praxisreflexion

In der Praxis zeigt sich ein wiederkehrendes Muster:

Organisationen investieren Zeit in Formulierungen von Disclaimern,

aber kaum Zeit in die Frage:

-

Wo darf das System überhaupt antworten?

-

Wo braucht es zwingend menschliche Freigabe?

-

Wo ist Eskalation vorgesehen?

Haftungsrisiken entstehen selten wegen eines einzelnen Satzes,

sondern wegen fehlender Prozesslogik.

Wo Haftung realistisch wird

Kritisch sind insbesondere Konstellationen, in denen:

-

Aussagen als verlässlich wahrgenommen werden,

-

kein klarer Eskalationspfad existiert,

-

oder Nutzer faktisch keine Alternative zur KI-Antwort haben.

In solchen Fällen genügt ein Disclaimer nicht.

Entscheidend ist, ob die Organisation Vorkehrungen getroffen hat, um Fehlwirkungen zu verhindern.

Kurze Einordnung für die Praxis

-

KI haftet nicht – Organisationen schon

-

Disclaimer steuern Erwartungen, nicht Verantwortung

-

Haftung folgt der Zurechnung, nicht der Technologie

-

Prozesse schlagen Texte

Selbsttest

-

Dürfte ein Kunde diese Aussage vernünftigerweise als verlässlich verstehen?

-

Gibt es eine klare Grenze, ab der menschliche Prüfung greift?

-

Ist dokumentiert, wofür das System eingesetzt werden darf – und wofür nicht?

Wenn eine dieser Fragen offen bleibt, liegt das Risiko nicht im Recht, sondern in der Organisation.

Einordnung

Haftung beim KI-Einsatz ist kein Tool-Problem, sondern ein Governance-Thema. Wer das versteht, braucht weniger Disclaimer – und trifft bessere Entscheidungen.