Warum «Datenschutz» als Killerargument bei KI selten stimmt

Jan 16, 2026

Kurzantwort

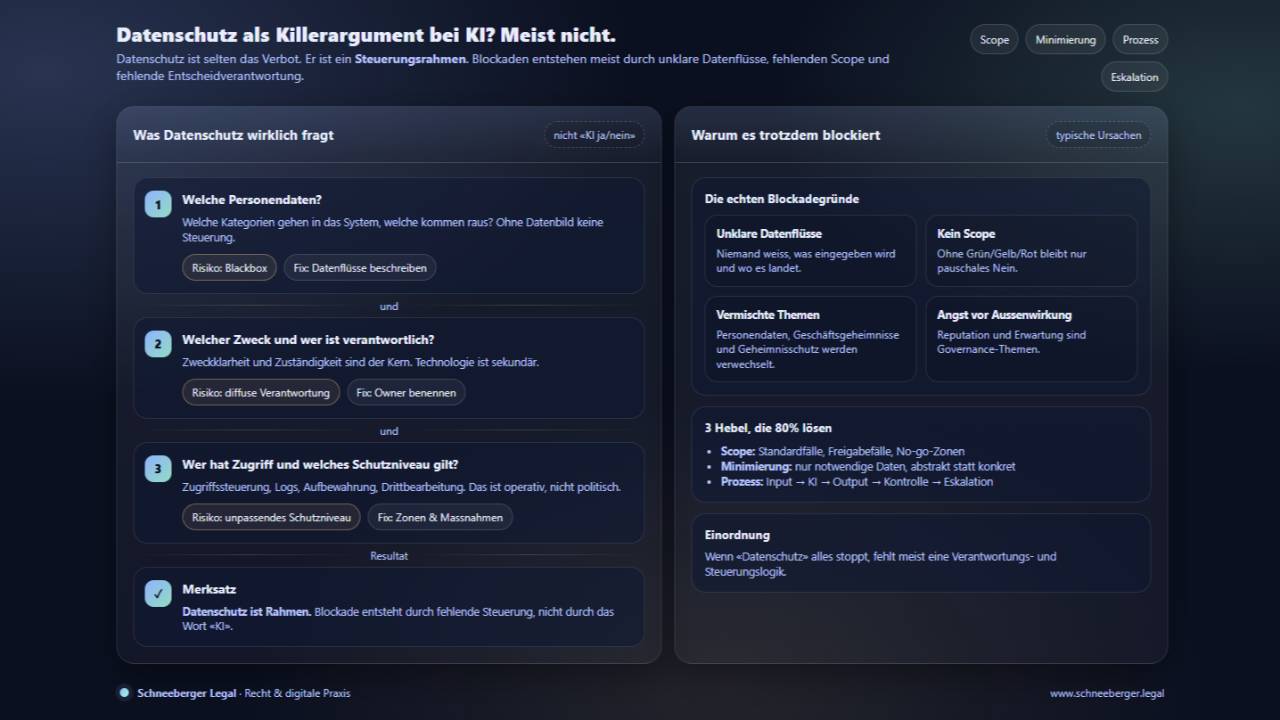

Datenschutz ist selten der eigentliche Showstopper. Er ist ein Rahmen, der Gestaltung verlangt. Das vermeintliche Killerargument ist meist etwas anderes: fehlende Verantwortlichkeit, ein ungeeignetes Setup oder die Scheu vor Entscheidungen.

Warum dieses Argument so häufig fällt

Sobald KI thematisiert wird, zeigt sich oft dasselbe Muster:

-

Ein Fachbereich erkennt Nutzen

-

Jemand bringt «Datenschutz» ins Spiel

-

Das Projekt stoppt

-

Alle sind erleichtert, weil niemand entscheiden muss

Datenschutz wird zur Abkürzung für Unsicherheit.

Der zentrale Denkfehler

Die implizite Annahme lautet:

Wenn Personendaten betroffen sind, ist KI unzulässig.

Das ist falsch. Personendaten werden täglich bearbeitet – auch ohne KI.

Datenschutz verbietet keine Technologie. Er verlangt Zweckbindung, Transparenz, Kontrolle und ein angemessenes Schutzniveau.

Was Datenschutz bei KI tatsächlich fordert

Datenschutz stellt nicht die Frage «KI ja oder nein», sondern:

-

Welche Personendaten werden bearbeitet?

-

Zu welchem Zweck?

-

Wer ist verantwortlich?

-

Wer hat Zugriff?

-

Welche Risiken entstehen für betroffene Personen?

-

Welche Massnahmen reduzieren diese Risiken?

Sind diese Fragen beantwortet, verliert «Datenschutz» seine blockierende Wirkung.

Warum es dennoch häufig scheitert

1) Unklare Datenflüsse

Es ist nicht klar, welche Daten in ein Tool gelangen, wo sie verarbeitet werden und wer darauf zugreift. In dieser Situation ist eine Blockade konsequent.

2) Fehlendes Schutzniveau-Konzept

Ohne Zonen, Stop-Regeln und Eskalation bleibt nur das pauschale Nein.

3) Vermischung von Personendaten und Geheimnissen

Datenschutz betrifft Personendaten. Geschäftsgeheimnisse sowie Amts- und Berufsgeheimnisse sind eigenständige Kategorien. In der Praxis wird dies oft vermengt und pauschal als «Datenschutz» bezeichnet.

4) Angst vor Aussenwirkung

Nicht das DSG blockiert, sondern die Sorge vor Reputationsschäden. Das ist kein Datenschutzproblem, sondern eine Frage von Governance und Erwartungsmanagement.

Was stattdessen erforderlich ist

Datenschutz wird handhabbar mit drei Elementen:

1. Klarer Scope (Grün / Gelb / Rot)

Welche Use Cases sind Standard, welche benötigen Freigabe, welche sind ausgeschlossen?

2. Datenminimierung

Nur die Daten verwenden, die notwendig sind. Alles andere weglassen, anonymisieren oder abstrahieren.

3. Prozess statt Tool-Fokus

Ein klarer Ablauf von Input über KI bis Output, Kontrolle und Eskalation macht Datenschutz operativ steuerbar.

Praxisreflexion

In den meisten Organisationen geht es nicht um «KI versus Datenschutz».

Es geht um «Nutzen versus Verantwortung». Datenschutz dient dabei oft als Vorwand, um Entscheidungen zu vermeiden.

Kurze Einordnung für die Praxis

-

Datenschutz ist ein Rahmen, kein Verbot

-

Blockaden entstehen durch Unklarheit, nicht durch KI

-

Scope und Minimierung lösen die meisten Fälle

-

Verantwortung und Eskalation lösen den Rest

Einordnung

Wenn «Datenschutz» alles stoppt, fehlt in der Regel nicht die Rechtsgrundlage, sondern die Fähigkeit, Datenflüsse und Risiken strukturiert zu steuern.

Selbsttest

-

Können Sie in zwei Sätzen erklären, welche Personendaten zu welchem Zweck in die KI gelangen?

-

Gibt es klare No-go-Zonen und definierte Freigaberegeln?

-

Ist festgelegt, wer bei Grenzfällen entscheidet?

Wenn nicht, liegt kein Datenschutzproblem vor, sondern ein Organisationsproblem.